Das World Wide Web hat sich in den letzten Jahrzehnten zu einer unüberschaubar großen Masse an Informationen entwickelt und wächst rasant weiter. Für Suchmaschinen wie Google ist es jedoch unmöglich, diese stetig wachsende Anzahl an Webseiten vollständig zu erfassen. Google crawlt daher nur eine bestimmte Anzahl an URLs pro Website, was unter SEOs auch als Crawl Budget bezeichnet wird. Warum dieses Konzept so wichtig ist und wie Du das Crawl-Budget Deiner Website optimieren kannst, erfährst Du in diesem Beitrag und in unserer Infografik.

Table of Contents

Warum ist das Crawl Budget so wichtig?

Damit Deine Website in den Suchergebnissen erscheinen kann, muss sie vorher vom Googlebot gecrawlt und indexiert werden. Ein effizientes Crawling ist dabei Voraussetzung dafür, dass alle wichtigen Seiten in den Suchmaschinenindex aufgenommen werden können. Deshalb ist es wichtig, den Googlebot so zu steuern, dass er alle wichtigen und hochwertigen Inhalte auf Deiner Website finden und crawlen kann. Maßnahmen, die darauf abzielen, werden unter dem Begriff der “Crawl Optimization” zusammengefasst und haben sich zu einem wichtigen Teilbereich der Suchmaschinenoptimierung (SEO) entwickelt.

Die Optimierung des Crawlings ist vor allem für große Websites mit sehr vielen Unterseiten (z.B. Online Shops) relevant. Dort kann es aufgrund der hohen Anzahl an URLs schnell passieren, dass Google sich zu lange auf irrelevanten Bereichen der Website aufhält, das Crawling daraufhin beendet und so die wichtigen Seiten gar nicht findet. Kleine und mittelgroße Websites mit wenigen Tausend URLs müssen sich in der Regel aber keine Sorgen machen. Google kann dort problemlos alle Unterseiten erfassen und in seinen Index aufnehmen.

Definition des Crawl Budgets

Bevor Du mit der Optimierung des Crawl Budgets Deiner Website beginnst, solltest Du dir darüber im Klaren sein, was der Begriff eigentlich bedeutet. Google hat hierzu einen ausführlichen Artikel auf seinem Webmaster Central Blog veröffentlicht. Die wichtigsten Aussagen haben wir hier kurz zusammengefasst:

Grundsätzlich ist Crawl Budget der Oberbegriff für zwei Konzepte: Crawl Rate & Crawl Demand.

- Crawl Rate bezieht sich auf die Anzahl der Verbindungen, mit denen der Googlebot Deine Website parallel crawlen kann. Dies hängt v.a. davon ab, wie schnell Dein Server antwortet und ob technische Fehler vorliegen.

- Crawl Demand beschreibt, wie wichtig Google Deine Website ist, und hängt von der Popularität dieser ab. Wenn Deine Website beispielsweise aufgrund von wenigen Backlinks und veraltetem Content für Google eher wenig interessant ist, wird die technisch mögliche Crawl Rate nicht zwangsläufig vollständig ausgenutzt.

Zusammengefasst beschreibt das Crawl Budget somit die Anzahl an URLs Deiner Website, die der Googlebot aus technischer Sicht crawlen kann und aus inhaltlicher Sicht auch crawlen möchte.

Faktoren, die das Crawl Budget negativ beeinflussen

Das Crawling und die Indexierung Deiner Website können durch verschiedene Faktoren negativ beeinflusst werden. Dazu gehören:

-

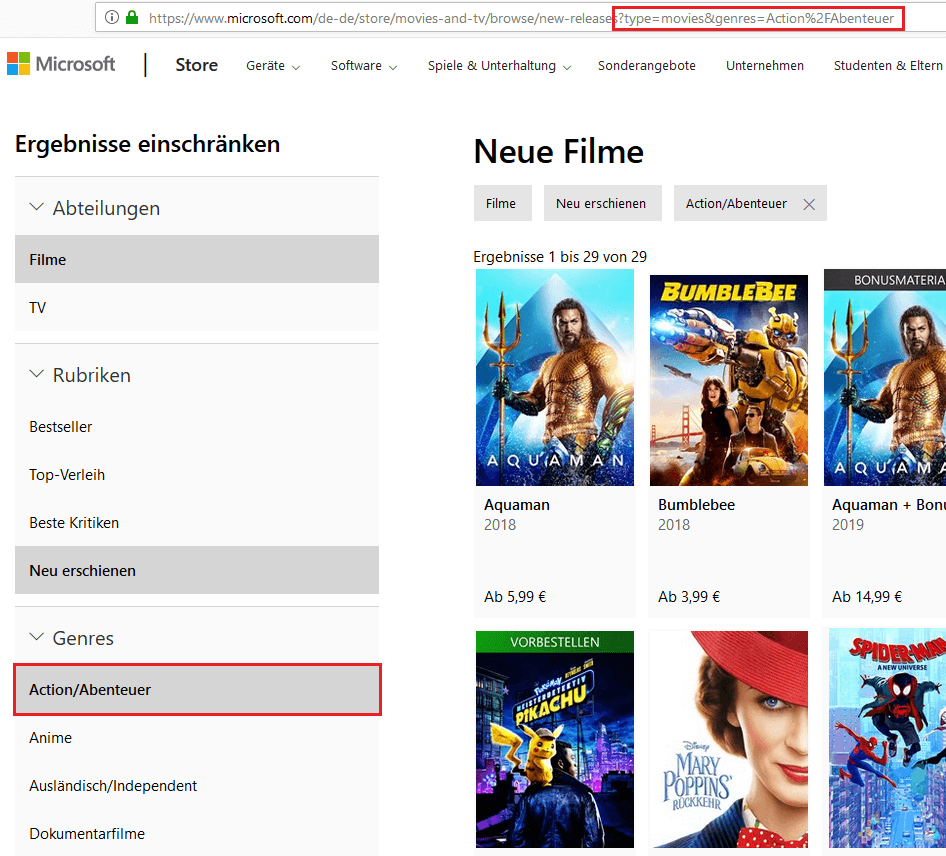

Faceted Navigation: Diese Art von Navigation wird häufig in Online-Shops eingesetzt. Dabei können die Ergebnisse für bestimmte Produktkategorien anhand von Kriterien wie Farbe oder Größe eingeschränkt werden. Hierfür werden URL-Parameter genutzt, wodurch viele neue URLs entstehen:

Screenshot von microsoft.com

In dem obigen Beispiel wird die Beschränkung der Ergebnisse auf das Genre “Action/Abenteuer” durch den URL Parameter &genres=Action%2FAbenteuer umgesetzt. Dadurch entsteht eine neue URL, die das Crawl Budget unnötig beansprucht, da die Seite keinen neuen Inhalt liefert, sondern nur einen Ausschnitt der Seite ohne diese Einschränkung darstellt.

-

Session-IDs in URLs: Diese führen zu endlos vielen verschiedenen URLs für den gleichen Inhalt und sollten nicht mehr genutzt werden.

-

Duplicate Content: Wenn der gleiche Inhalt auf mehreren Seiten zu finden ist, müssen mehr URLs gecrawlt werden, um ein und denselben Inhalt zu erfassen. Dabei können Kapazitäten für relevanten und einzigartigen Content auf anderen Seiten verloren gehen.

-

Soft Error Seiten: Hierbei handelt es sich um Seiten, die (im Gegensatz zu 404 Fehlerseiten) zwar aufgerufen werden können, aber nicht den gewünschten Inhalt liefern. Der Server gibt dabei den Statuscode 200 zurück, kann aber nicht auf die eigentliche Seite zugreifen.

-

Gehackte Seiten: Google möchte seinen Nutzern stets die bestmöglichen Ergebnisse liefern und manipulierte Seiten gehören hier definitiv nicht dazu. Wenn Google solche Seiten auf Deiner Website entdeckt, schränkt der Bot daher das Crawling ein.

-

Infinite Spaces: Infinite Spaces entstehen zum Beispiel durch eingebundene Kalender, bei denen man unendlich weit in die Zukunft blättern kann:

Screenshot von deutsches-museum.de

Wie in dem Beispiel zu sehen ist, wird bei jedem Klick auf den nächsten Kalendermonat eine neue URL erzeugt. Dies kann theoretisch unendlich oft geschehen, sodass eine riesige Masse an URLs entsteht, die der Googlebot einzeln abrufen muss.

-

Content von niedriger Qualität (thin content) oder Spam-Content: Google möchte solche Seiten nicht im Index haben und reduziert deshalb das Crawling, wenn solche Inhalte auf Deiner Website auftauchen.

-

Lange Weiterleitungsschleifen: Wird auf Weiterleitungen verlinkt, muss der Googlebot mehrere URLs aufrufen, bis er zum eigentlichen Inhalt kommt. Google macht die Aufrufe nicht direkt hintereinander, sondern behandelt diese wie einzelne Seiten, sodass hier das Crawl Budget unnötig verschwendet wird.

-

Cache Buster: Hierbei handelt es sich um Ressourcen wie CSS Dateien, die Namen haben wie style.css?2345345. Der durch das Fragezeichen angehängte Parameter wird bei jedem Abruf dynamisch generiert und soll verhindern, dass die CSS-Datei von Web Browsern gecached wird. Das hat allerdings den Nachteil, dass der Googlebot eine Vielzahl dieser Ressourcen URLs vorfindet und diese unnötigerweise abruft.

-

Fehlende Redirects: Wenn generelle Redirects für www. und nicht-www sowie für http und https nicht korrekt eingerichtet sind, führt das dazu, dass sich die Anzahl der crawlbaren URLs verdoppeln bzw. sogar vervierfachen kann. So wäre beispielsweise die Seite www.example.com theoretisch unter vier URLs vorhanden, wenn kein Redirect konfiguriert ist, nämlich:

http://www.example.com

https://www.example.com

http://example.com

https://example.com -

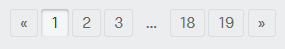

Schlechte Paginierung: Wird eine Paginierung lediglich durch Vor- und Zurück-Links (also ohne klickbare Seitenzahlen) umgesetzt, muss der Googlebot sehr viele einzelne Seiten abrufen, um die komplette Paginierung zu erfassen. Stattdessen empfiehlt es sich, eine Seitennummerierung ähnlich wie die folgende umzusetzen:

Screenshot von kleiderkreisel.de

Hier kann der Googlebot direkt von Seite 1 auf die letzte Seite der Paginierung navigieren und damit schneller alle zu crawlenden Seiten erfassen.

Wenn einer oder mehrere der oben beschriebenen Faktoren auf Deine Website zutreffen, solltest Du dich auf jeden Fall mit der Optimierung des Crawl Budgets auseinandersetzen. Ansonsten kann das dazu führen, dass Bereiche Deiner Website, die einen tatsächlichen Mehrwert und hochwertige Inhalte bieten, von Google gar nicht entdeckt werden, da der Bot zu sehr damit beschäftigt ist, irrelevante Seiten zu crawlen.

Wie Du das Crawl Budget Deiner Website erhöhen und effizienter nutzen kannst

Im Rahmen der Crawl Budget Optimierung werden meist zwei Ziele verfolgt: Zum einen soll das insgesamt verfügbare Crawl Budget erhöht und zum anderen das bestehende Crawl Budget effizienter genutzt werden. Nachfolgend stellen wir Dir mögliche SEO Maßnahmen für beide Ansätze vor.

Wie Du das Crawl Budget Deiner Website erhöhst

-

Serverantwortzeit und Pagespeed verbessern: Wenn Dein Server Seitenaufrufe schnell beantwortet, kann der Googlebot mehrere Verbindungen gleichzeitig nutzen, um den Content Deiner Website zu crawlen. Dadurch steigt die Crawl Rate und somit auch das insgesamt verfügbare Crawl Budget. Die Optimierung des Pagespeeds Deiner Website ist ohnehin eine unverzichtbare SEO Maßnahme, da der Pagespeed ein wichtiger Rankingfaktor ist. In unserem Wiki findest Du eine ausführliche Beschreibung möglicher Maßnahmen zur Verbesserung des Pagespeeds. Besonders wichtig hierbei: je weniger Anfragen zum Laden einer Seite an den Server gesendet werden müssen, desto weniger wird das Crawl Budget beansprucht.

-

Server Fehler vermeiden: Eine funktionierende technische Infrastruktur ist eine wichtige Voraussetzung dafür, dass Google möglichst viele URLs parallel von einem Webserver abrufen kann. Du solltest daher sicherstellen, dass alle Seiten auf Deiner Website den Statuscode 200 (OK) oder 301 (permanente Weiterleitung) zurückgeben.

-

Crawl Demand erhöhen: Um Google dazu zu bringen, möglichst oft auf Deiner Website vorbeizuschauen, musst Du Deine Seiten für die Suchmaschine interessant machen. Das ist zum Beispiel durch den Aufbau von Backlinks möglich. Backlinks signalisieren Google, dass Deine Seite von anderen Seiten Empfehlungen erhält und daher höchstwahrscheinlich guten Content liefert. Da Google solche Seiten in seinem Index stets aktuell halten möchte, besucht der Googlebot Seiten mit vielen Backlinks öfter.

Ein weiterer Weg, um den Crawl Demand zu erhöhen, ist es, die Interaktion von Nutzern mit Deinen Inhalten zu fördern und die Verweildauer Deiner Besucher zu erhöhen. Ebenso zeigt ein hohes Ausmaß an Social Sharing, dass Deine Website scheinbar teilenswerte Inhalte bietet. Um Google auf Deine Website zu locken, solltest Du außerdem regelmäßig frische Inhalte liefern.

Wie Du das Crawl Budget Deiner Website effizienter nutzt

Auch wenn sich das Crawl Budget bis zu einem gewissen Grad erhöhen lässt, ist es für große Websites ebenso wichtig, effizient mit dem vorhandenen Crawl Budget umzugehen. Das schaffst Du durch folgende Maßnahmen:

-

Irrelevante Inhalte vom Crawling ausschließen: In einem ersten Schritt solltest Du alle Seiten auf Deiner Website, die für Suchmaschinen irrelevant sind, durch Angaben in der Robots.txt Datei vom Crawling ausschließen. Hierzu zählen beispielsweise Log-in Seiten, Kontaktformulare, URL-Parameter u.ä. In unserem Wiki Artikel findest Du eine ausführliche Beschreibung zur Funktionsweise und möglichen Anweisungen in der Robots.txt.

Aber Achtung: Wenn Seiten per Robots.txt vom Crawling ausgeschlossen wurden, bedeutet das auch, dass Google wichtige Meta Informationen wie Canonical Tags oder noindex Anweisungen nicht mehr finden und somit auch nicht berücksichtigen kann.

-

Nofollow verwenden: Auch wenn viele Webseitenbetreiber eher davor zurückschrecken, nofollow für interne Links zu verwenden, ist auch dies eine Möglichkeit, um den Googlebot von irrelevanten Seiten fernzuhalten. Beispielsweise kann nofollow in obigem Kalender Beispiel für den Link genutzt werden, mit dem der nächste Monat aufgerufen wird, um die Entstehung von Infinite Spaces zu vermeiden. Allerdings geht dabei auch wertvoller Linkjuice verloren, weshalb immer im Einzelfall abgewogen werden sollte, ob eine Blockierung über die Robots.txt nicht doch der bessere Weg ist.

-

URL-Parameter vermeiden: URL-Parameter sollten grundsätzlich vermieden werden. Ist dies nicht möglich, sollten die Parameter in der robots.txt vom Crawling ausgeschlossen werden, sofern sie nicht für das Erreichen von relevantem Inhalt nötig sind.

-

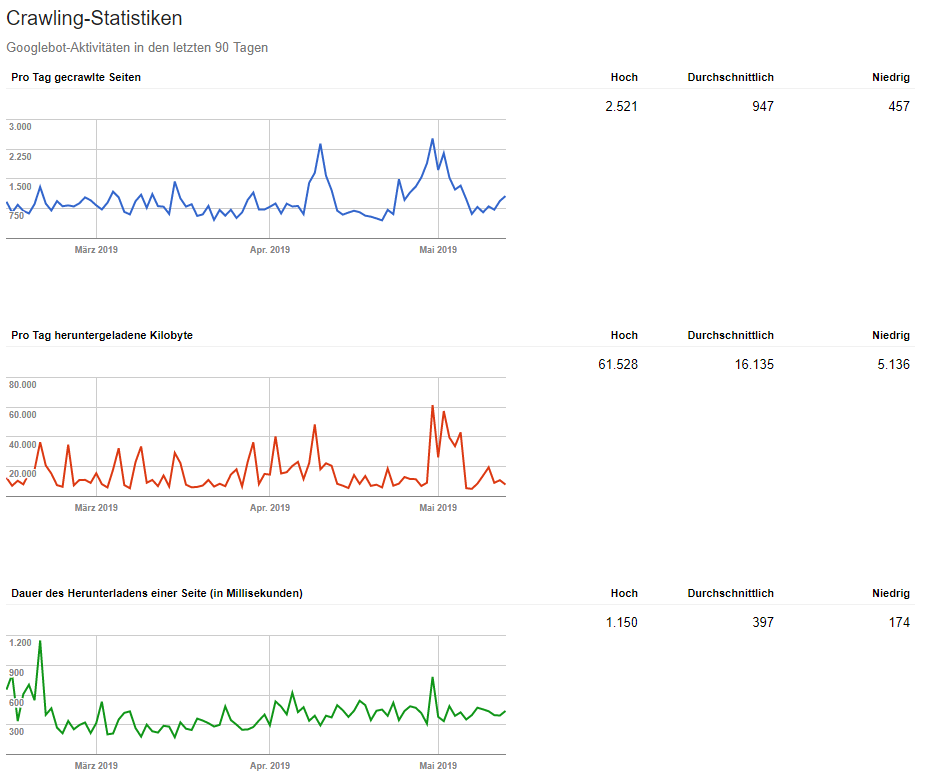

Flache Seitenarchitektur: Mit einer flachen Seitenarchitektur kannst Du sicherstellen, dass alle Unterseiten Deiner Website mit nur wenigen Klicks von der Startseite aus erreichbar sind. Dies ist sowohl für User als auch für Suchmaschinen Crawler von Vorteil. Für das Crawling ist das insbesondere deshalb wichtig, da Suchmaschinen Crawler zu tief liegende Seiten Deiner Website möglicherweise nicht mehr besuchen. Eine flache Seitenarchitektur lässt sich am einfachsten durch eine HTML Sitemap realisieren, in der alle wichtigen Unterseiten Deiner Website aufgelistet sind. Können die Links nicht alle auf einer HTML-Seite untergebracht werden, kann die Sitemap auch über mehrere Hierarchien verteilt und beispielsweise nach dem Alphabet sortiert werden:

Screenshot von stepstone.de

-

Interne Verlinkung optimieren: Suchmaschinen Crawler bewegen sich entlang von internen Links durch Deine Website. Daher kannst Du die interne Verlinkung gezielt einsetzen, um die Crawler zu steuern. Beispielsweise kannst Du Seiten, die häufiger gecrawlt werden sollen, auf Seiten verlinken, die bereits viele Backlinks besitzen und daher mit einer hohen Wahrscheinlichkeit von Google besucht werden. Auch generell sollten wichtige Unterseiten intern gut verlinkt sein, um Google die Relevanz dieser Seiten zu signalisieren. Zudem sollten sie nicht weit von der Startseite entfernt sein. Einen ausführlichen Leitfaden zur Optimierung der internen Verlinkung findest Du hier.

-

Bereitstellen einer XML-Sitemap: Mit einer XML-Sitemap hilfst Du Google dabei, sich einen Überblick über Deine Website zu verschaffen. Damit wird das Crawling beschleunigt und die Wahrscheinlichkeit sinkt, dass hochwertiger und wichtiger Content unentdeckt bleibt.

-

Links nicht auf Weiterleitungen setzen: Sowohl interne als auch externe Links, die auf Deine Website führen, sollten niemals auf eine weiterleitende URL gesetzt werden. Denn im Gegensatz zu Web Browsern folgt der Googlebot Weiterleitungen nicht direkt, sondern Schritt für Schritt. Das bedeutet: wenn der Server dem Googlebot eine URL zurückgibt, auf die er weitergeleitet werden soll, speichert der Bot diese URL erst einmal ab und folgt ihr später. Damit steigt die Gefahr, dass wichtiger Content in der Masse an zu crawlenden URLs untergeht.

-

Weiterleitungsschleifen vermeiden: Wie oben bereits erklärt wurde, erhöhen Weiterleitungsschleifen die Anzahl an URLs, die vom Server abgerufen werden müssen, und verbrauchen damit unnötiges Crawl-Budget. Aus diesem Grund sollte immer direkt auf die Ziel-URL weitergeleitet werden.

-

Regelmäßig Content prüfen: Wenn Deine Website sehr viele Unterseiten besitzt, solltest Du regelmäßig Deinen Content überprüfen und an geeigneten Stellen zusammenführen oder löschen. Damit kannst Du Duplicate Content vermeiden und sicherstellen, dass jede Unterseite relevanten und einzigartigen Content beinhaltet.

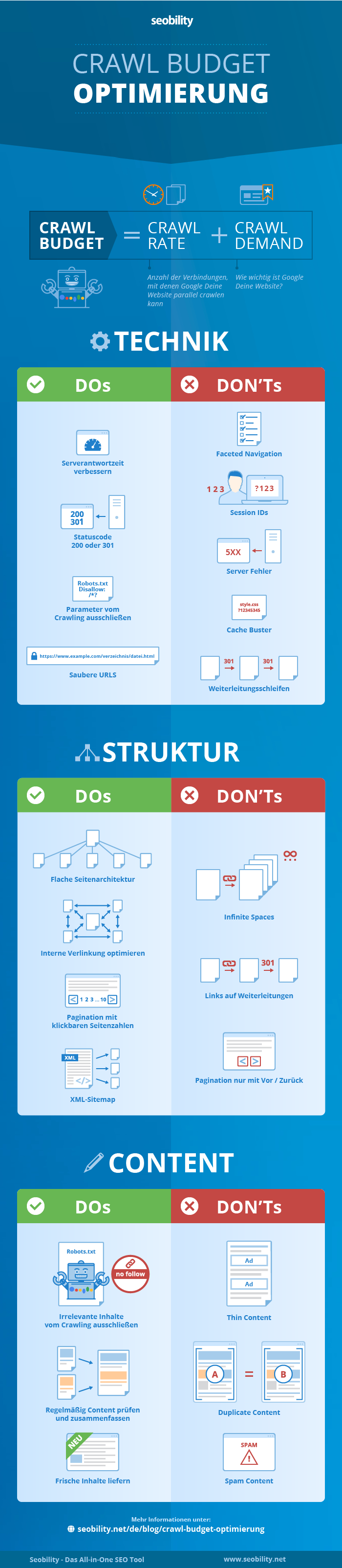

Infografik „Crawl Budget Optimierung“

Wie Du siehst muss im Rahmen der Crawl Budget Optimierung eine Menge beachtet werden. Damit Du dabei nicht den Überblick verlierst, haben wir die wichtigsten Dos and Don’ts in der folgenden Infografik für Dich zusammengefasst:

Monitoring Tipps

Wie viele andere SEO Maßnahmen auch, ist die Crawl Budget Optimierung keine Aufgabe, die Du an einem Tag erledigen kannst. Stattdessen ist regelmäßiges Monitoring und Optimieren erforderlich, um sicherzustellen, dass Google nur die wichtigen Seiten auf Deiner Website besucht. Daher möchten wir Dir abschließend noch ein paar Tipps und Tools für die Erfolgsüberwachung mitgeben.

-

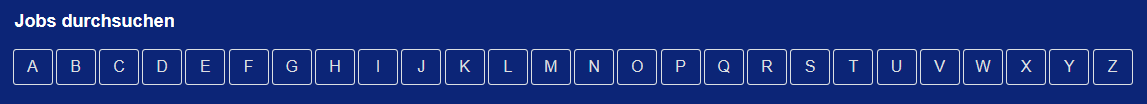

Crawling Statistiken in der Search Console: In der (alten) Google Search Console kannst Du im Bereich “Crawling-Statistiken” die Anzahl der pro Tag gecrawlten Seiten auf Deiner Website für die letzten 90 Tage abrufen:

-

Logfile-Analyse: In sog. Logfiles protokollieren Web Server jeden Zugriff auf Deine Website und speichern Informationen wie IP-Adresse, User Agent etc. Durch eine Analyse dieser Logfiles kannst Du herausfinden, welche Seiten der Googlebot besonders häufig crawlt und darauf basierend beurteilen, ob es sich hierbei um die richtigen (also relevanten) Seiten handelt. Außerdem kannst Du herausfinden, ob es Seiten gibt, die aus Deiner Sicht zwar sehr wichtig sind, aber von Google überhaupt nicht besucht werden.

-

Bericht zur Indexabdeckung: Dieser Bericht in der Search Console zeigt Dir Fehler an, die bei der Indexierung Deiner Website aufgetreten sind (z.B. Server-Fehler) und damit das Crawling beeinträchtigen.

Screenshot von search.google.com/search-console/index

Screenshot von google.com/webmasters/tools/crawl-stats

Dort kannst Du prüfen, ob Deine Optimierungsmaßnahmen tatsächlich zu einer Erhöhung des Crawl Budgets geführt haben.

Fazit

Auf den ersten Blick können die oben beschriebenen Optimierungsmaßnahmen vielleicht etwas erschlagend wirken, aber im Grunde geht es nur um eines: Sorge für eine technisch einwandfreie Funktionalität und eine gute Struktur auf Deiner Website. Damit stellst Du sicher, dass Suchmaschinen den wichtigen Inhalt auf Deiner Website schnell finden können, und schaffst die Grundvoraussetzungen für ein effizientes Crawling. Hast Du das geschafft, kann sich Google voll und ganz auf Deinen Content konzentrieren und muss sich nicht mit Fehlerseiten oder irrelevanten Inhalten herumschlagen.

Hinweis: Onpage Crawler wie Seobility können Dir dabei helfen, den Arbeitsaufwand zu minimieren, indem sie automatisch Deine Website crawlen und auf Fehler und Optimierungspotentiale überprüfen.

PS: Erhalte neue Blog Artikel direkt in Dein Postfach!

11 Gedanken zu „Crawl Budget Optimierung: So verbesserst Du das Crawling Deiner Website“

Hallo,

Macht es Sinn.css/?223. in der Rotos.txt mittels Wildcard auszuschließen?

Gruß Freddy

Hallo Freddy,

bei sehr großen Websites kann es Sinn machen, CSS-Dateien mit dynamischen Parametern in der Robots.txt auszuschließen, um das Crawl Budget zu schonen. Allerdings solltest Du beachten, dass Google oft auch CSS-Dateien lädt, um die Darstellung einer Webseite auf mobilen Endgeräten zu prüfen. Daher ist hier Vorsicht geboten.

Schöner Artikel. Sehr hilfreich. 🙂

Hey Jan, danke für das positive Feedback! ?

Guten Morgen,

da ich blutiger Anfänger bin erschlagen mich die vielen Infos.

Werde mich so nach und nach einarbeiten und die vielen Beiträge lesen.

Danke für die ausgezeichneten Seiten

Guter Artikel und nett zum Lesen. Ich denke jeder der sich daran hält wird auf seiner Seite schnelle Verbesserungen bemerken. Man muss Google verstehen um Google richtig für einen arbeiten zu lassen 😉

Übrigens finde ich es gut, dass ihr immer viele Beispiele bringt.

Hallo Patrick,

danke für das Lob!

Wir versuchen unsere Texte immer mit vielen Beispielen so verständlich und praxisnah wie möglich zu schreiben. Freut uns, dass das auch von unseren Lesern wahrgenommen und geschätzt wird ?

Ich liebe euren Blog!

So viele wichtige Informationen und so verständlich geschrieben, ich kann immer wieder nur Danke für Eure tolle Arbeit sagen.

Grüße aus Berlin

Karsten

Hallo Karsten, vielen Dank für die netten Worte! ?

Hallo liebes SEOBILITY Team.

Danke für die Infos, guter Artikel. Bei dem Begriff Paginierung komme ich dann doch ins Straucheln. Was war das doch gleich nochmals???? Ach ja…… Guter Hinweis, aber in der Erklärung etwas verwirrend wegen Duplicate Content.

Hallo Robert,

vielen Dank für Dein Feedback! Eine Paginierung bzw. Pagination ist eine Seitennummerierung, d.h. Website Inhalte werden auf mehrere Seiten aufgeteilt. Mehr Informationen dazu findest Du auch in unserem Wiki Artikel: https://www.seobility.net/de/wiki/Pagination

Wir möchten, dass unsere Artikel für jeden verständlich sind, wenn Du also noch weitere Fragen hast, dann melde Dich gerne bei uns!